Bit of a change of pace, vandaag. Ik was het eerlijk gezegd uit het oog verloren tot gisteren, dat de drie dagen eigenlijk drie helemaal verschillende dagen waren.

Dag één was Designing Products, dag twee was Designing For People, vandaag was het Designing the Future. En kijk: elke spreker vandaag was op zijn/haar eigen manier interessant.

AI is your new design material – Josh Clark

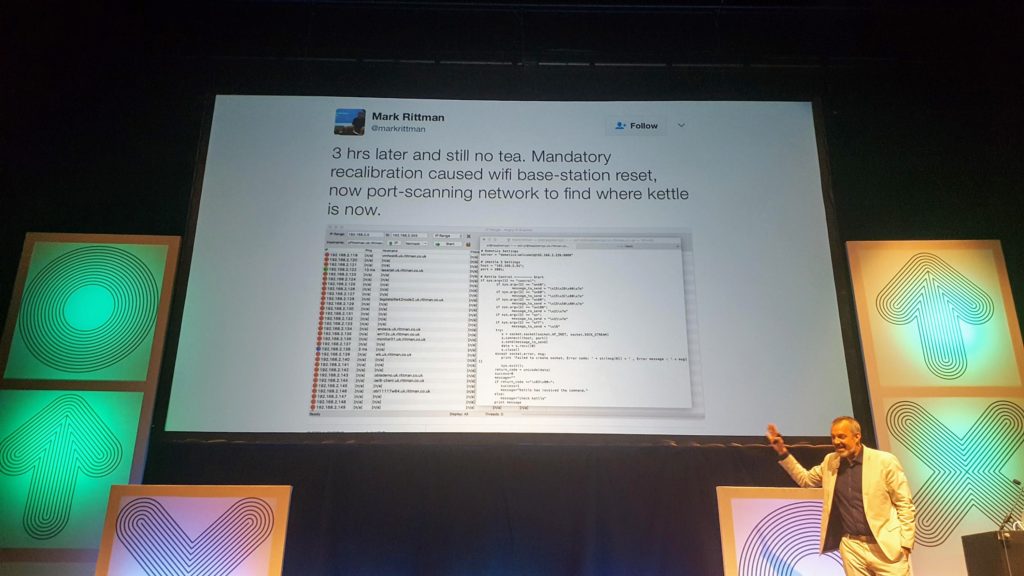

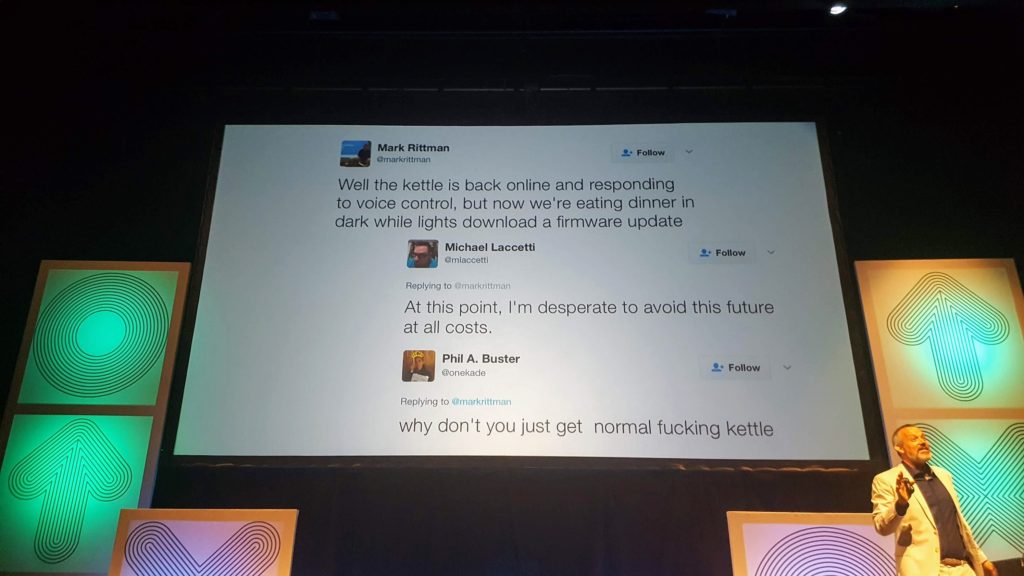

De sympathieke Josh Clark zette de dag in met een aantal grappige voorbeelden: Juicero, de rampzalige internetgeconnecteerde niet-eens-fruitpers, de fysieke fruitpers van Philippe Starck, een internetgeconnecteerde warmwaterkoker.

Designers tegenwoordig, zegt hij, hebben te vaak een te groot ego, worden verliefd op het ding dat ze aan het maken zijn, en werken te vaak ergens op het kruispunt van technologie en hubris.

Technologie is er niet voor de technologie, maar om het potentieel van mensen te versterken. En net zoals twintig jaar geleden html en css een designmateriaal was dat tegenwoordig onderverstaan wordt overal gebruikt te kunnen worden zonder er bij na te denken, net zoals hetzelfde opgaat sinds een jaar of tien met het idee van “mobiel”, is tegenwoordig data, machine learning en artificiële intelligentie een gegeven waarmee design gedaan kan/moet worden.

Als we die dingen willen kunnen gebruiken, moeten we ze begrijpen. Niet noodzakelijk de algoritmes of wat er achter de schermen gebeurt, maar wel wat het kan doen, wat de sterktes en zwaktes zijn, en hoe het ons en de wereld kan veranderen.

Wat als we overal patronen zouden kunnen in herkennen, en daar iets mee zouden kunnen doen? Dat kan tegenwoordig namelijk, op verschillende manieren:

- Recommendations: Slack raadt u mensen aan op basis van de inhoud van uw gesprekken: geen menselijke tagging nodig, maar machinegestuurde interpretatie.

- Voorspellingen: predictive typing op uw telefoon, raadt welke woorden uw zin zullen aanvullen op basis van al wat ge ooit geschreven hebt in het verleden.

- Classificatie: begin op Google Forms uw enquêtevraag met “wat vindt u van…” en Forms stelt u een Lickertschaal voor, begin met “welke van de volgende…” en Forms stelt een checkboxlijst voor.

Dat zijn dus geen enorm grote of revolutionaire dingen: net zoals het idee van degelijke UX niet revolutionair of groot meer is, is het meer “sprinkel er wat machine learning op” dan “schakel de AI-laboratoria in!”. Maar het wil wel zeggen dat we er tegenwoordig absoluut even vertrouwd moeten zijn als we met mobile of micro-interacties zijn. En dat is absoluut mogelijk, want al wat machine learning is, is tegenwoordig helemaal commoditized, en de Groten Der Aarde (Amazon, Microsoft, Google, IBM) struikelen over elkaars voeten om het gratis in onze richting te smijten.

Mensen worden niet vervangen door AI, maar machines doen waar zij goed zijn (lastige, tijdrovende, repetitieve, detailgericht en foutgevoelige taken), en dat geeft mensen de kans om goed te zijn waar wij goed in zijn. Designers kunnen computers gebruiken om problemen op te lossen die de moeite waard zijn, maar die zonder computers praktisch niet haalbaar zijn, zoals:

- gericht vragen stellen, door gebruik te maken van ML-analyse in plaats van brutekracht door de data te slingeren

- volledig nieuwe vragen stellen, door in een call center bijvoorbeeld uit data die dat niet noodzakelijk op het eerste zicht duidelijk maakt, te weten te komen of een probleem dringend is of niet

- nieuwe gegevensbronnen ontsluiten (massale hoeveeldeden tekst, spraak, handgeschreven materiaal, …)

- onzichtbare en niet-intuïtieve patronen naar boven halen, zoals klantensegmenten of groepergingen van gedragingen

*

* *

Clark vervolgt met een aantal designpatronen en ideeën.

Machines zijn raar: ontwerp voor falen en onzekerheid

AI-conclusies kunnen verrassend zijn. Ze hebben niet noodzakelijk iets te maken met hoe wij de werkelijkheid zien — denk aan hoe Google Deepmind zichzelf leerde lopen:

Daar zitten enerzijds opportuniteiten in, in de zin dat we allerlei inzichten kunnen krijgen uit het onverwachte, maar aan de andere kant is het ook risicovol. Als we rekenen op machines om dingen te doen, moeten we ontwerpen voor falen en onzekerheid.

Door de band gaan we er van uit dat het ding dat we ontwerpen, zal werken zoals het zou moeten werken, of dat het tenmiste op voorspelbare manieren niét zal werken. Met AI is dat anders: het kan op interessante manieren verkeerd lopen (voor een gegeven waarde van “interessant”).

Om daar mee om te gaan, stelt Clark de term B.A.S.A.A.P voor: Be As Smart As A Puppy. Probeer als computer zo weinig arrogant mogelijk te zijn, gedraag u nederig, anticipeer dat ge fouten gaat maken en bereid mensen daarop voor.

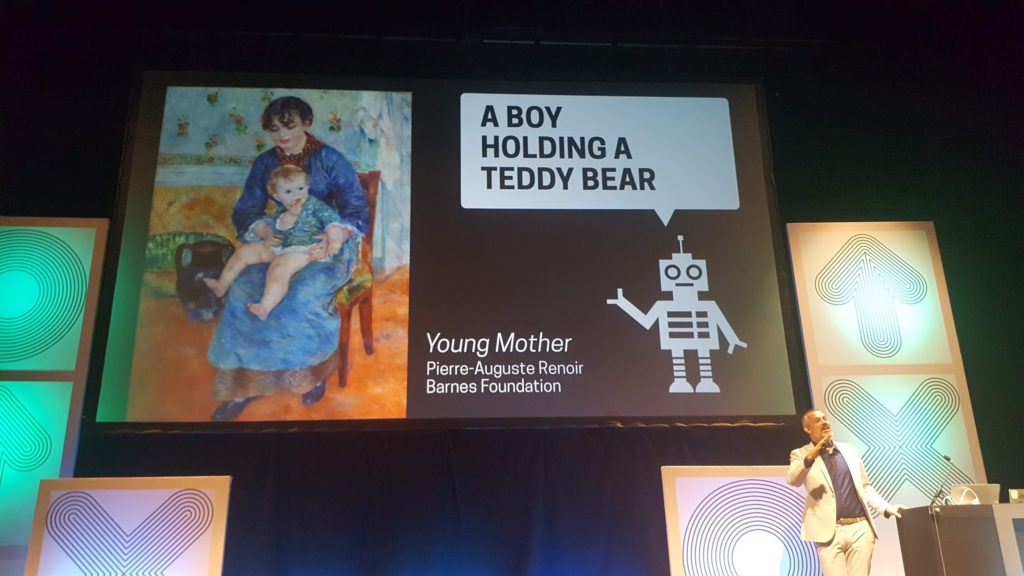

Het slechtste dat een AI kan doen, is overdreven veel zelfvertrouwen hebben. Mensen hebben veel liever een correct maar vaag antwoord dan een zeer specifiek maar fout antwoord: liever “een persoon die iets vast heeft (misschien een teddybeer?)” dan “een jongen met een teddybeer”.

Machines zijn probabilistisch: gebruik signalen, geen absoluten

Niets staat 100% vast in machine learning, niets is zwartwit. Als ik deze foto

doorgeef aan Microsoft’s Cognitive Services, geeft die mij als omschrijving ” a group of people standing on a sidewalk”. Dat ziet er redelijk categoriek uit, maar als ik de output van het ding in detail bekijk, ziet die er zo uit:

| Tags | [ { “name”: “ground”, “confidence”: 0.998708367 }, { “name”: “person”, “confidence”: 0.997296154 }, { “name”: “footwear”, “confidence”: 0.996109843 }, { “name”: “jeans”, “confidence”: 0.9915272 }, { “name”: “outdoor”, “confidence”: 0.960992157 }, { “name”: “trousers”, “confidence”: 0.936603 }, { “name”: “boot”, “confidence”: 0.9043827 }, { “name”: “clothing”, “confidence”: 0.875633955 }, { “name”: “shoe”, “confidence”: 0.8364543 }, { “name”: “sandal”, “confidence”: 0.6584058 } ] |

| Description | { “tags”: [ “person”, “outdoor”, “child”, “standing”, “young”, “little”, “girl”, “group”, “small”, “people”, “playing”, “woman”, “boy”, “sidewalk”, “sitting”, “holding”, “riding”, “shoes”, “yellow”, “man”, “walking”, “park”, “board”, “city”, “phone”, “street” ], “captions”: [ { “text”: “a group of people standing on a sidewalk”, “confidence”: 0.7962945 } ] } |

Het ding was maar 79% zeker van die omschrijving, en haalde die uit een reeks tags waar ook “woman” en “child” en “phone” bij stond. En daarboven zien we dat het 99,9% zeker was dat er “ground” op de foto stond en 99,6% dat er “footwear” op stond, maar niet meer dan 83% dat er schoenen op de foto stond.

Het is bijzonder verraderlijk te denken dat “de machine” ons één antwoord geeft: alles is percentages, en daar moeten we mee kunnen omgaan. Zo was het vorig jaar even een schandaal dat Amazon’s gezichtsherkenning dacht dat congresleden misdadigers waren, maar bij nader inzien was dat enkel omdat de “zekerheidsgraad” op 80% stond:

“While 80% confidence is an acceptable threshold for photos of hot dogs, chairs, animals, or other social media use cases,” an Amazon representative said, “it wouldn’t be appropriate for identifying individuals with a reasonable level of certainty.” Amazon instead recommends that law enforcement agencies use a higher confidence threshold when attempting to identify wanted individuals. The company says it advises at least a 95 percent threshold.

Zo’n dingen, in een design, moeten met andere woorden enorm transpaant gemaakt worden voor de gebruiker. En “ik weet het niet” is vaak een beter antwoord dan een fout antwoord. Of als dat niet aanvaardbaar is, kan een antwoord een suggestie worden in plaats van iets categorieks.

Machines hebben geen gezond verstand: garbage in, garbage out

Machine Learning anno nu begrijpt de data niet maar ziet er alleen maar patronen in. Dat wil zeggen dat de output maar zo goed kan zijn als de input — een beroemd geval was toen Amazon iets geschreven had om zo objectief mogelijk, zonder tussenkomst van mensen, CV’s te beoordelen. Bleek dat het algoritme het niet zo voor vrouwen had — niet noodzakelijk omdat vrouwen slechter zouden presteren, maar omdat het getraind was op de sollicitaties van de vorige tien jaar. Daar zaten nu eenmaal mee mannen bij, wat het algoritme er toe bracht om zelfs maar vermelding van vrouwen te penaliseren.

Stom naturlijk, maar niet de fout van de computer. En eigenlijk ook wel nuttig, achteraf gezien, want het brengt een aantal van die biases aan de oppervlakte, wat het mogelijk maakt om ze aan te pakken.

*

* *

Hoe dat allemaal onze toekomst gaat veranderen? Voor Clark komt het er op neer dat we in de (nabije) toekomst AI en ML intentioneel moeten gaan gebruiken.

De dokter niet vervangen door een machine, maar de machine het diagnosewerk laten doen, en de boodschap laten brengen door een dokter, bijvoorbeeld.

Het domme maar technisch moeilijke werk kan door een machine gebeuren, het werk waar mededogen, creativiteit en inzicht voor nodig is, kunnen mensen doen.

Het komt er op aan om de twee samen te doen werken, elk waar ze goed in zijn.

Designing for the Triple Storyline – Erika Hall

Erica Hall was frustrerend: 45 minuten spreken om iets te zeggen dat op 20 minuten had gekund, en (volgens mij) een nodeloos slecht gestructureerde talk.

Zo begon ze met een heel stuk dat de toekomst vroeger beter was, en met een aantal mythes van UXD, om dan pas in de tweede helft van haar betoog naar de kern van de zaak te gaan, grr.

We houden ons voor de zot als we denken dat bedrijven human-centered werken voor het goed van hun klanten. Dat duurt net zo lang tot ze de keuze moeten maken tussen een businessmodel en human-centered zijn, en als die keuze er komt, moét uit de bedrijfslogica het businessmodel winnen.

Gebeurt dat niet, gaat het bedrijf failliet. En ja, er kan genuanceerd worden met korte en lange termijn en watnog, maar gegeven de keuze tussen geld en overleven aan de ene kant en een fantastische gebruikerservaring aan de andere kant, moéten ze geld en overleven kiezen.

Dat leidt tot een aantal paradoxale gevolgen:

- Goede UX is niet altijd goed voor gebruikers: wie weet is de UX wel goed, maar wordt achter de schermen de data van de gebruikers verkocht? Of zou de gebruiker eigenlijk best méér keuze krijgen dan de “goede UX” hem geeft?

- Goede UX is niet altijd goed voor het bedrijf: Uber lijkt goed te draaien omdat de UX zo goed is, maar eigenlijk is de prijs een wezenlijk onderdeel van de dienst, en zou die in aanmerkingen moeten genomen worden bij het design. (Uber heeft nog altijd geen winst gemaakt, voor zover ik weet.)

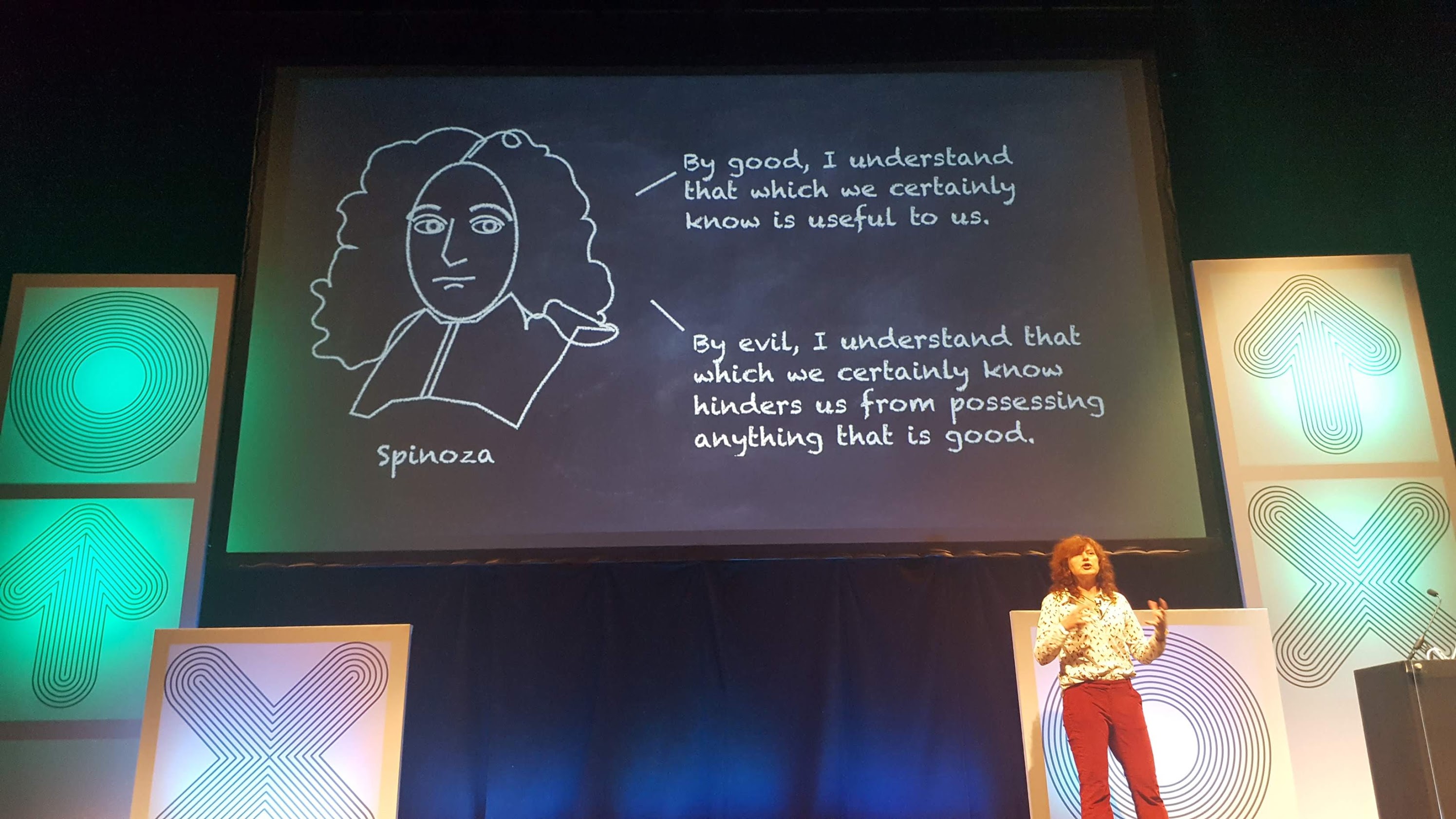

- Goede UX is niet altijd Goed: we kunnen een fantastisch ontworpen tool maken om mensen mee te stalken, bijvoorbeeld. Of een uitstekend werkend online casino. “Goed” is een bijzonder relatief begrip: we moeten ons altijd de vraag stellen “goed voor wié?”

Vandaar dat Hall voorstelt om af te stappen van (enkel) user-centered design, en in de plaats gaan kijken naar zowel users als business als het hele systeem.

Dan moeten we ons vragen stellen over wat er allemaal van waarde wordt uitgewisseld tussen verschillende actoren: tijd, geld, persoonlijke gegevens, milieuvervuiling, energieverspilling, …

Moeten we beseffen dat elke beslissing, ook die van een manager om geld te geven of niet, in de grond een designbeslissing is — en moeten we als “designers” ook op dat niveau mee zijn, en verder kijken dan onze nauwe UX-doos.

Moeten we eerst vragen waarom? vóór we beginnen na te denken over het hoe? van een design.

En ja, het is lastig en vervelend om verder te denken dan wat traditioneel onze job is, maar het zou eigenlijk onze verplichting moeten zijn. Want we weten bijvoorbeeld dat niets gratis is, en dat als we iets ontwerpen waar iets gratis weggegeven wordt, dat er altijd iets ethisch niet pluis aan is.

Zoals ik altijd al zeg dat werkgevers en werknemers fundamenteel andere wezens zijn, met fundamenteel andere drijfveren en finaliteiten, zo zegt Hall dat business en design fundamenteel twee verschillende kanten van de wereld zijn, die eigenlijk nooit volledig kunnen verzoend worden.

Business is kwantificeerbaar, user experience is uit zijn aard een kwalitatief iets dat niet enkel in cijfers kan gegoten worden.

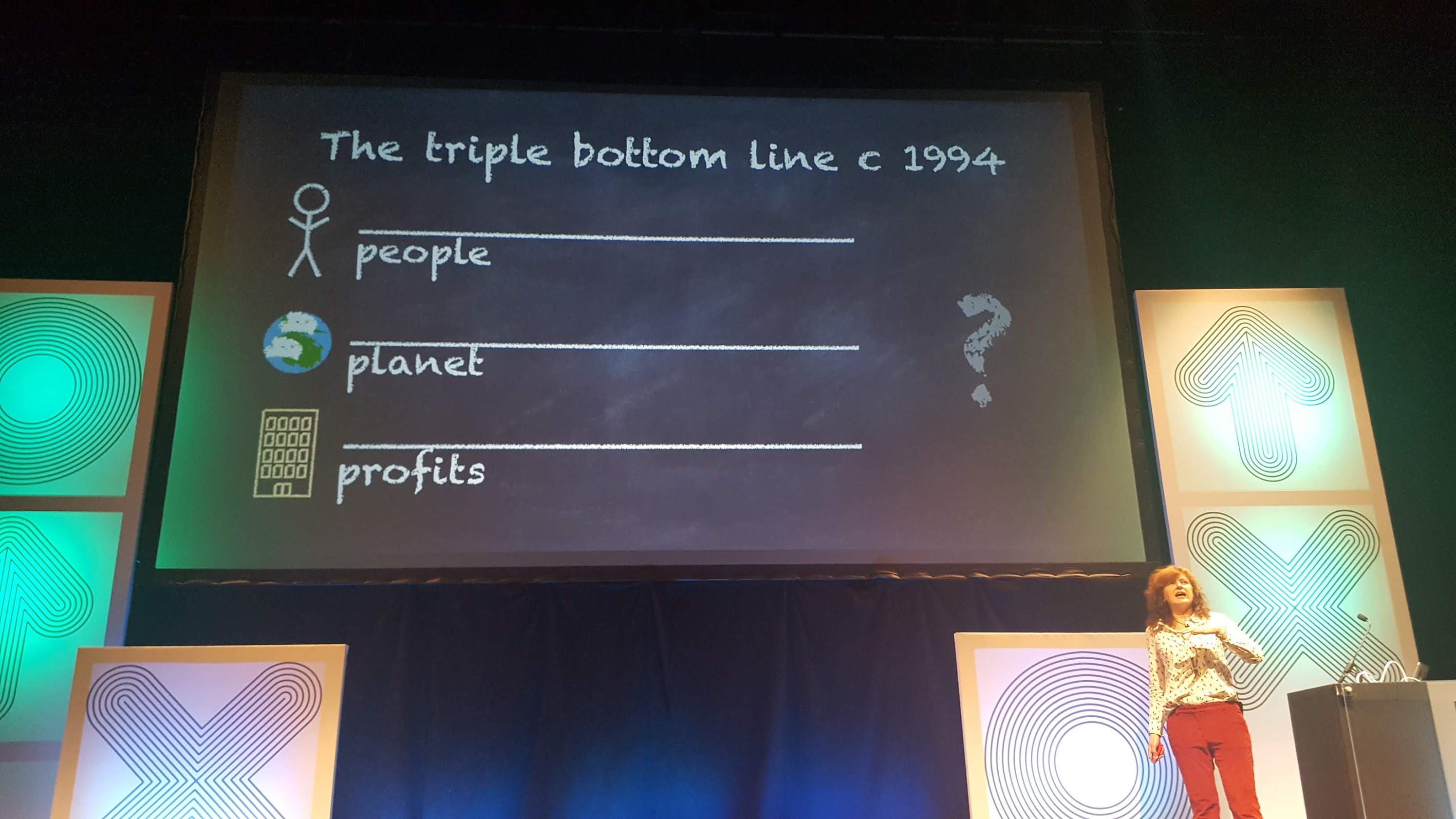

Mensen proberen dat dan te verzoenen, zoals John Elkington met zijn Triple bottom line: denk altijd aan de verhouding tussen people, planet en profit. Die trok een hele golf van Corporate Social Responsibility mee op gang, maar na verloop van tijd werd die meer gebruikt als excuus om de drie P’s in een grafiekje te steken en kruideniersgewijs tegen mekaar af te wegen, en daarmee meer gewetens te sussen dan wat anders. In die mate dat Elkington zelf het concept officieel ingetrokken heeft:

It was supposed to provoke deeper thinking about capitalism and its future, but many early adopters understood the concept as a balancing act, adopting a trade-off mentality.

John Elkington, 2018

*

* *

Hall doet niet enkel doom & gloom. Ze geeft een mogelijke oplossing om die drie factoren met elkaar te verzoenen en stelt voor om met verhalen te werken. Meer bepaald, met Kurt Vonnegut’s story graphs:

(Tussen twee haken: ik had het bovenstaande filmpje al lang geleden gezien, en ik was meer dan een beetje teleurgesteld dat Erika Hall het verhaal van Assepoester letterlijk probeerde te vertellen zoals Vonnegut het deed. Dat was meer dan parafraseren, het was plagiaat. Ik was kwaad, zelfs. Nem.)

Door op zo’n story graph de lijn van de gebruikerservaring uit te zetten naast een lijn voor het bedrijf of het geld, komen we tot interessante conclusies:

- als de geldlijn voortdurend bovenaan staat maar de ervaringslijn onderaan, is het een saai bedrijf

- als de ervaringslijn bovenaan staat maar de geldlijn onderaan, is het misschien wel een cool bedrijf, maar verdient het geen geld

- alleen als de twee lijnen op den duur positief zijn, is er sprake van een gezonde situatie

…en om het verhaal helemaal compleet te maken, moet er nog een derde lijn bij: naast mens en bedrijf, ook een lijn voor planeet of systeem.

En zo komen we aan de Triple Storyline uit de titel van de talk.

Designers moeten zich telkens de vraag blijven stellen of ze door een klein probleem op te lossen niet een veel groter probleem creëren. Ze kijken daarvoor best naast Warren Buffett, die niet investeert in zaken die hij niet begrijpt: doe geen design voor zaken waar je het gevolg niet van kan inschatten, en werk enkel op plaatsen waar je waarde toevoegt voor mens, bedrijf én planeet. (Of niet noodzakelijk de hele planeet, maar hou minstens rekening met de ruimere omgeving.)

Zet een stap terug, denk niet alleen aan mogelijke kortetermijngevolgen maar ook aan de gevolgen in de toekomst, en streef naar een toekomst die zowel waardevol als winstgevend is.

Ik vond dat een interessante premisse. Viel bijna totaal uit de toon in vergelijking met de rest van de dag, maar wel stof voor discussie. Ik zou graag meer willen gezien hebben over de rol van de overheid en andere organismen die niet noodzakelijk winst moeten maken (middenveld en vrijwilligers bijvoorbeeld), maar als korte smaakmaker was het zeer de moeite.

Spijtig van de warrige presentatie en het schaamteloos plagiëren, maar hey, so it goes.

Anticipatory Design & The Future Of Experience – Sarah Doody

Sarah Doody contrasteerde automated design met anticipatory design, . Bij het eerste worden dingen automagisch gedaan vóór u, en is het eigenlijk de bedoeling dat er geen beslissingen meer genomen hoeven te worden. Bij het tweede wordt er geanticipeerd op uw noden en wordt ge geholpen om een beslissing te nemen, maar moet ge zelf wel nog actie ondernemen.

We hebben tegenwoordig allemaal te lijden onder decision fatigue, waar computers en telefoons niet bij helpen. Ik kan vanalles kopen online, maar er zijn zelfs in één winkel veel te veel alternatieven om een keuze te kunnen maken zonder stress. Ik kan Netflix open doen, maar daar moet ik uit zó een enorme stapel dingen een keuze maken, dat ik er op voorhand moe van word.

Hoe kan design daarbij helpen?

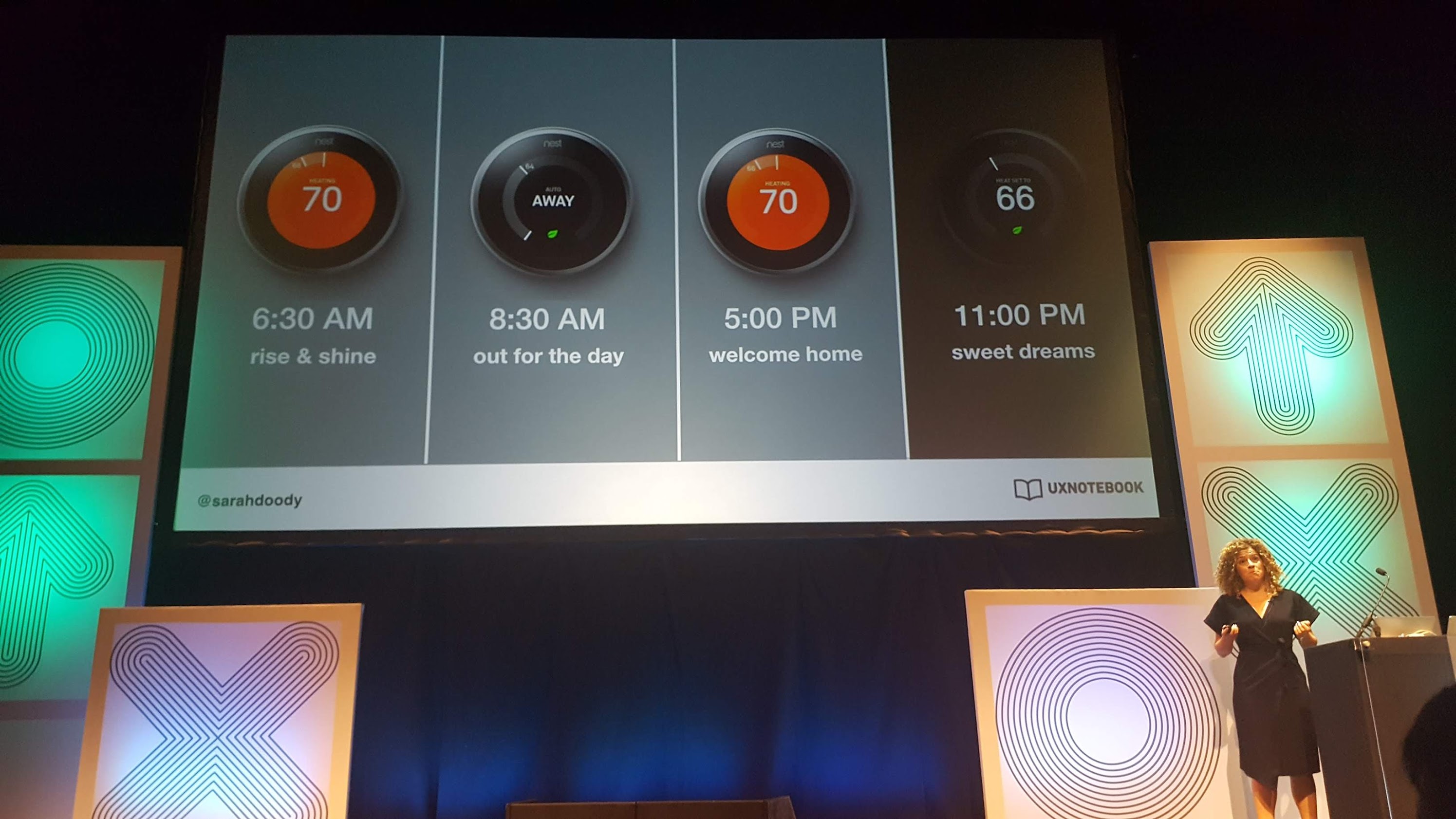

Dingen zoals een thermostaat van Nest nemen u de beslissing uit handen: ge moet helemaal niets meer doen. Dat is een gemak, maar het schept ook wel risico’s:

- Wat als de automagische beslissing fout is? Kunnen we gemakkelijk ingrijpen en corrigeren? Wat gebeurt er als de automatie faalt?

Met een thermostaat is er geen enorm groot probleem, maar als we kijken naar de automatische piloot in vliegtuigen: piloten vliegen tegenwoordig gemiddeld maar drie minuten manueel per vlucht, wat leidt tot deskilling — ze vergeten gewoon hoe ze moeten vliegen als de automatische piloot het laat afweten. - Als alles automatisch gebeurt, waar komt innovatie vandaan? Bij Toyota zijn ze om die reden robots beginnen vervangen door mensen: een robot zal nooit het grotere beeld zien en effeciëntiewinst voorstellen. (En daarnaast is een robot nooit zo flexibel als een mens, die op geen tijd een ander model auto kan in elkaar steken, waar een robot helemaal moet geherprogrammeerd worden.)

- Denk aan de frictie van Steve Selzer van gisteren: wat gebeurt er met de gebruikerservaring als we niets zelf meer moeten doen? En wat gaan we met al onze vrije tijd doen?

Doody stelt drie designprincipes voor:

- Tranparantie: zorg ervoor dat mensen gemakkelijk de controle kunnen overnemen en beslissingen ongedaan kunnen maken.

- Curatie: mensen vertrouwen algoritmes niet, en beginnen “recommendation blindness” te krijgen (zie ook: banner blindness). Kijk naar kwaliteit en niet kwantiteit, als het op aanbevelingen aankomt. En laat die door mensen gestuurd worden.

- Vertrouwen: werk aan een systeem van geven en nemen, en vertel gebruikers waarom ze om bepaalde gegevens gevraagd wordt.

Het was al met al een zeer (zeer) lichte presentatie. Er is ook niet zeer veel van blijven hangen, sorry. Ik had mijn notities hard nodig om dit te schrijven. 🙂

Designing for AI – Emily Sappington

Emily Sappington werk voor Babylon Health, de startup waar Jane Austin ook voor werkt. Zij geeft in het heel kort een antwoord op een vraag die ze meer dan veel krijgt: “hoe kunnen we AI doen?”.

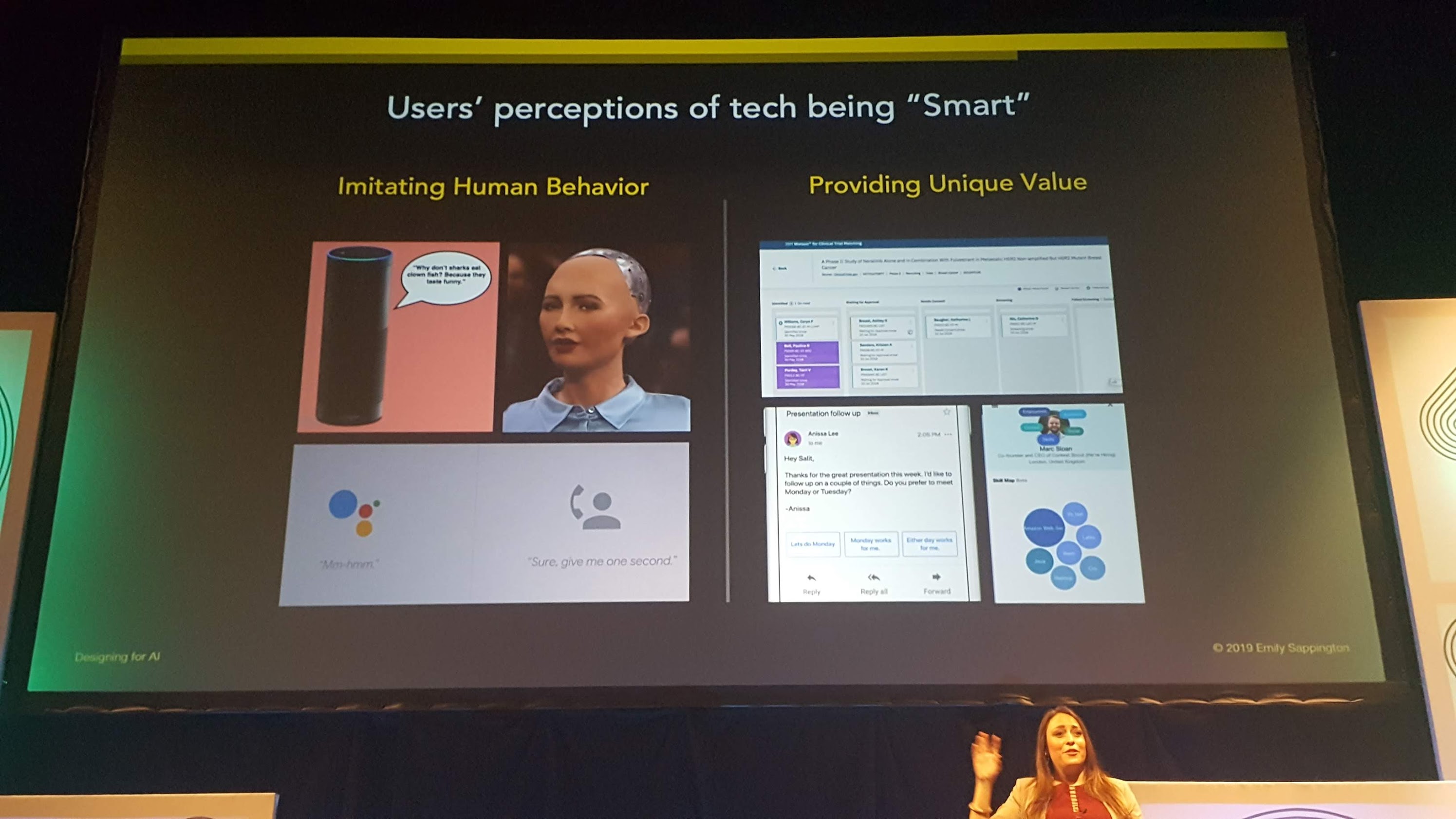

Design voor AI, voert ze aan, moet zich laten inspireren door hoe mensen kijken of iemand anders intelligent is:

- doet het iets als ik iets doe? — denk met een stok een kwal op het strand een duw geven om te zien of het leeft dan wel dood is

- spreek ik met iemand die competent is? kan ik hem vertrouwen?

(merk daarbij op dat dat niet rationeel is: mensen schatten in dat iemand die naar de grond kijkt tijden een interview minder intelligent is dan iemand die recht in de camera kijkt, ongeacht of die persoon “echt” intelligent is of niet) - kan die mens iets beter dan mij? ben ik ervan onder de indruk?

Vertaald naar technologie, geeft dat:

- Is de software responsief? (In de zin van “geeft het snel antwoord”: hoe goed een resultaat ook mag zijn, als het dertig seconden duurt om het te hebben, riskeert het systeem zeer hard dom te lijken.)

- Kan ik er eenvoudige basistaken mee uitvoeren?

- Sta ik ervan versteld? Lijkt het een echte mens? Spaar ik er tijd mee uit? Doet het wat een echte mens zou doen, maar in een fractie van een seconde?

De volgorde is belangrijk: 1 en 2 zijn waar gebruikers uw product of dienst uittesten. Het is ook waar vertrouwen gewekt of verloren wordt: als iets als Siri er zelfs niet in slaagt om een wekker in te stellen, waarom zou ik er dan mijn bankgegevens aan doorspelen om er een online betaling mee te doen?

Sappington hamert op het belang van expectation management: zorg ervoor dat de gebruiker geen al te grote verwachten heeft, als die niet gegarandeerd ingelost kunnen worden.

Het is het idee van “kruip voor ge wandelt, wandel voor ge loopt”: mensen liggen meer wakker van wat een machine voor hen kan betekenen, dan dat die machine zich precies als een mens gedraagt.

Praktisch dus, op een rij:

- schep de juiste verwachtingen

- doe méér dan de gebruiker van u verwacht

- doe een paar dingen zeer goed, eerder dan veel dingen middelmatig goed

Specifiek voor startups:

- gebruik voice enkel als dat zinvol is voor zowel gebruikersscenario, toestel van de gebruiker als gebruiksomgeving

- doe enkel personalisatie als dat echt nodig is, zoals bij Babylon Health, waar u bijvoorbeeld enkel om uw gewicht gevraagd wordt als dat in de context echt nodig is

Dat wil in de praktijk zeggen dat features die niet perfect werken, niet naar de gebruiker mogen gaan. En dat het soms nodig is om (eventueel tijdelijke) hulpmiddelen in te bouwen, zoals multiple choice in plaats van een volledige chat-interface.

“Goede” AI, zegt Sappington, zorgt ervoor dat gebruikers zich meer competent voelen, dat ze tijd en moeite besparen, en dat ze hij eigen hersenen gebruiken. “Slechte” AI geeft mensen de indruk dat ze stom zijn, en doet ze tijd verliezen.

Samenvattend, geeft ze de volgende vuistregels voor Minimum Viable Intelligence:

- doe een aantal dingen uitstekend

- wees eerst slim, en dan pas intelligent

- underpromise, overdeliver

- verras gebruikers met intelligentie in de juiste context

Tja. ’t Was wel interessant, maar ook zeer algemeen. En zeer kort. Ik had het liever technischer gehad. Of meer in de diepte.

Designing Agentive Technology – Chris Noessel

De laatste spreker! Van IBM zowaar! En mega-interessant!

In onze handen klappen, dat is iets dat we bewust doen en kunnen controleren. Spijsvertering, dat is iets dat we onbewust doen en niet kunnen controleren. Ademen, dat is iets dat we door de band onbewust doen, maar dat we óók kunnen controleren.

Daar zit een patroon, zegt Chris Noessel.

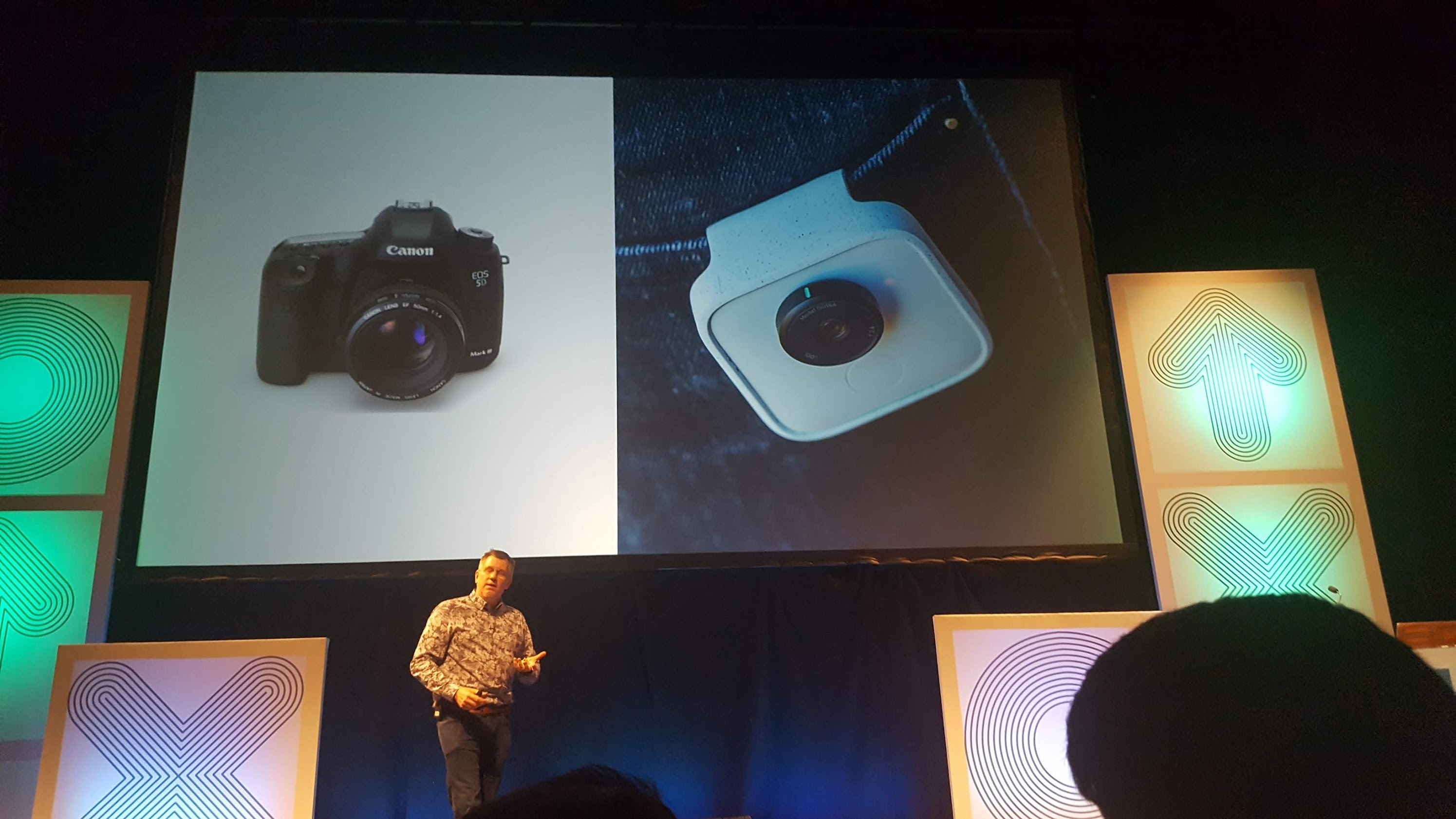

Er zijn fototoestellen zoals dat link, waar een fotograaf foto’s mee maakt, maar er is ook Google Clips, een camera zonder fotograaf, die foto’s en films maakt zonder tussenkomst.

Net zoals er al lang stofzuigers zijn waar mensen mee stofzuigen, maar sinds een tijdje ook stofzuigers die zelf stofzuigen, zoals de Roomba.

Of zoals er auto’s zijn waar chauffeurs mee rijden, maar binnenkort ook auto’s zonder chauffeur.

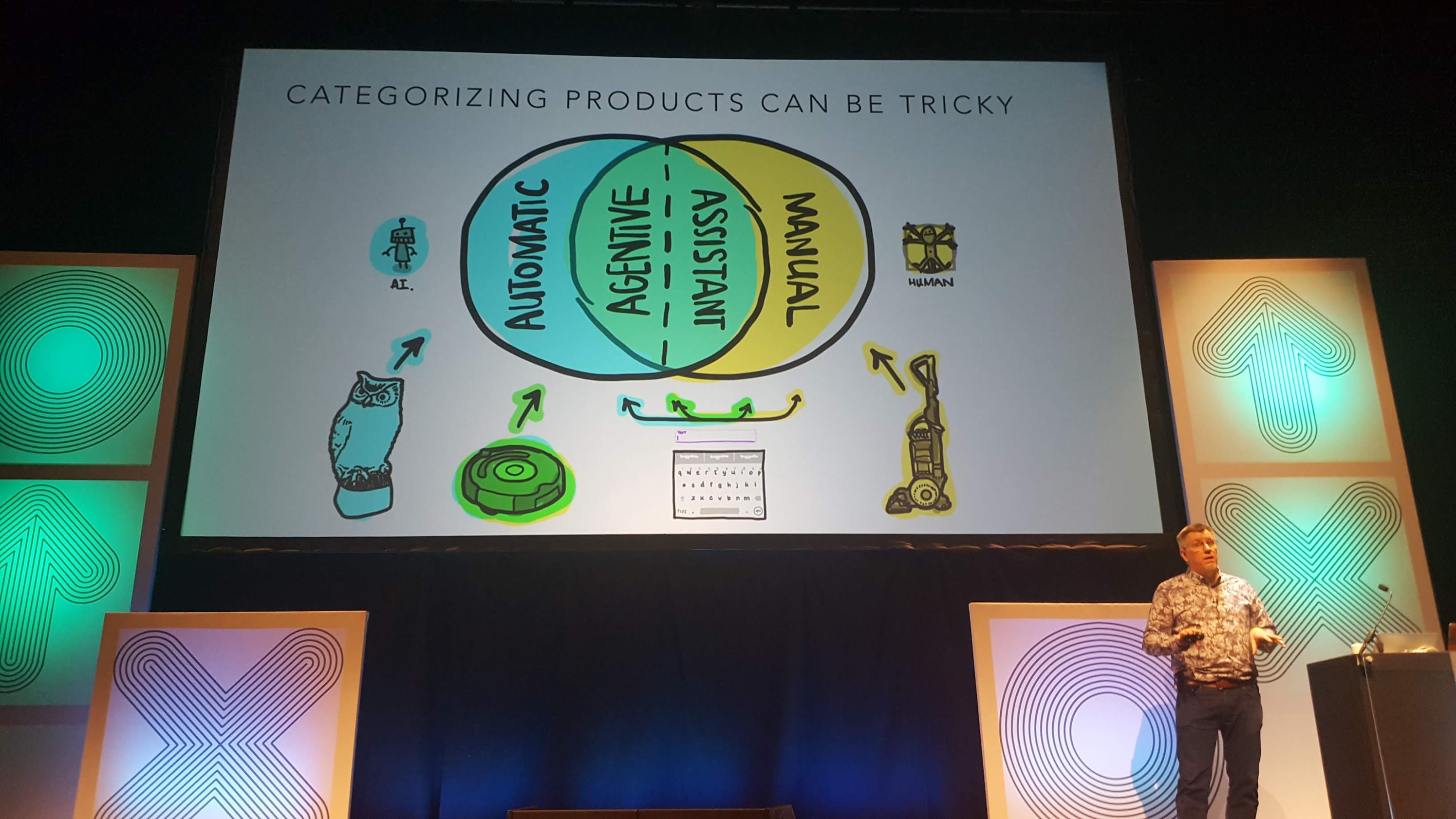

En ook dat is een patroon, zegt : een ding waar vroeger een mens iets mee deed, dat nu zijn ding kan doen zonder mens.

Dingen die handelingsvermogen (agency) krijgen zonder dat een gebruiker in de buurt moet zijn, noemt Noessel agentive technology. En dat blijft niet noodzakelijk bij first world problems zoals automatische stofzuigers of camera’s:

- Shotspotter detecteert waar er schoten afgevuurd worden, en krijgt op die manier ordediensten sneller ter plaatse.

- Kitestring is een soort automatische chaperone voor mensen die met onbekende mensen op date gaan.

- Tertill wiedt onkruid op zichzelf.

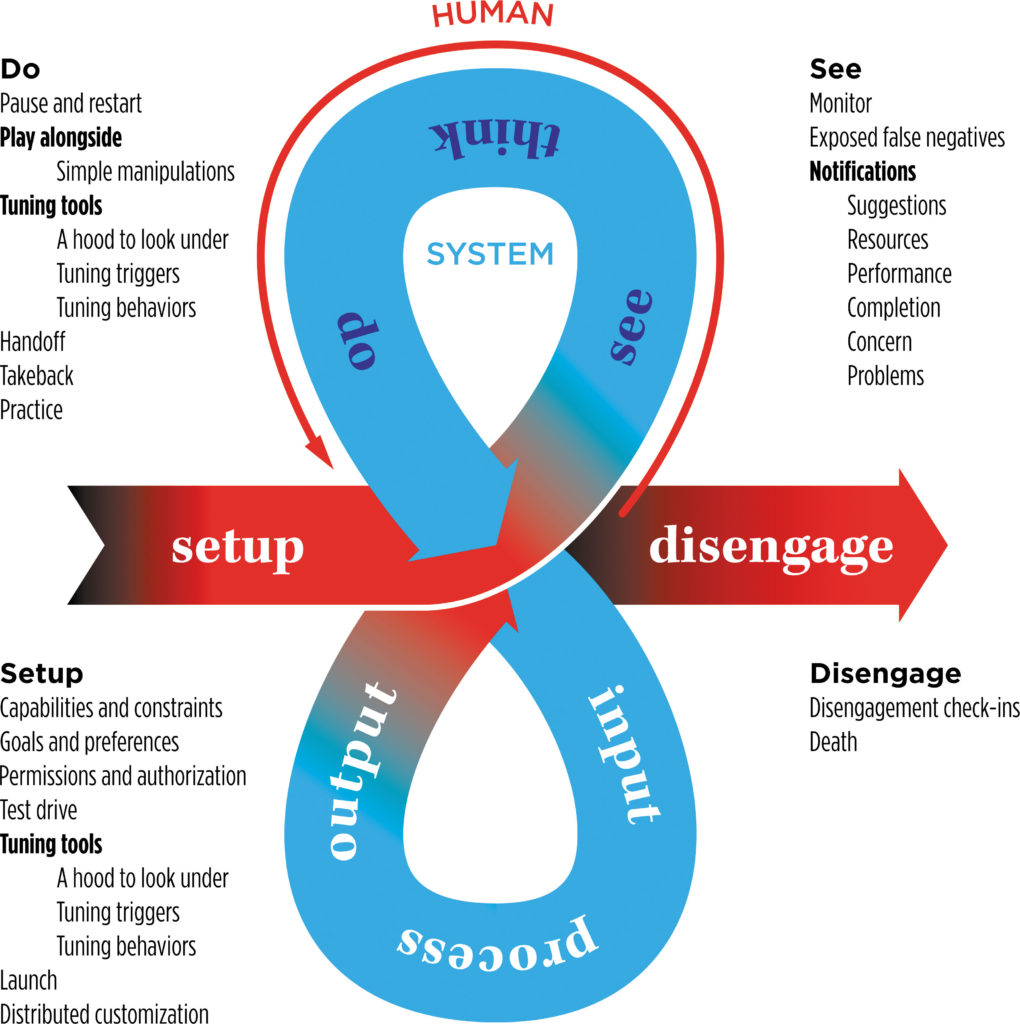

Om de vergelijking met willekeurige, onwillekeurige en gemengde lichaamsfuncties te maken:

- er is een manuele modus, waarbij de mens al het werk doet

- er is een automatische modus, waarbij er een bewuste poging is om de computer (of de machine) zoveel mogelijk werk te laten doen zonder menselijke tussenkomst

- er is een interactieve modus, waarbij we mens en machine samen doen werken: de mens ziet iets, denkt na, doet iets, dat dient als input voor een machine, die een proces uitvoert en outpout geeft, die de mens ziet, etc.

- …en Noesser voegt daar nu een agentieve modus aan toe

Wat is daar speciaal aan? Het is iets relatief nieuw: de autopiloot bestaat al sinds 1914, maar tegenwoordig is alle mogelijke AI zo commoditized dat het praktisch geworden is om agentieve systemen op zeer eenvoudige manier zelf te maken.

Het introduceert een hele reeks nieuwe en machtig interessante patronen in interactieontwerp:

Het is het summum van user-centredheid. Als we het voorbeeld van koffie nemen, zijn we op een paar eeuwen tijd van grondstof (koop uw bonen bij de boer en brand ze) naar product (betaal wat meer voor het gemakt om uw pak gebrande koffie in de winkel te kopen en maak thuis koffie) naar dienst (betaal wat meet en koop een tas koffie in een café) naar experience (betaal u blauw aan koffie in een Starbucks of bij uw lokale barista) gegaan.

Maar al die dingen vragen nog een volgehouden aandacht van de gebruiker — agentieve technologie vraagt geen zelfs geen volgehouden aandacht of interactie meer.

Het zorgt voor een threshold: eens voor iets agentieve technologie gebruikt wordt, wordt het moeilijk terug te keren naar vroeger. Als iemand een Roomba heeft, zal hij niet rap de neiging hebben om zelf nog te gaan stofzuigen. Als ik in een zelfrijdende auto naar mijn werk kan gaan, ga ik zeker nooit een rijbewijs halen.

Noessel verloor mij een beetje als hij beweerde dat agentieve technologie een hele reeks nieuwe concepten introduceert zoals last-mile personalisation (met personas kunnen we pakweg 80% van de personalisatie vatten, preferences en setting doen daar misschien nog 10 of 15% bij, maar nu kunnen we alles totaal hyperpersonaliseren), Spotify- en andere personal discovery, en zelfs existentiële discovery in het heelal (met vermoed ik dan agentieve Von Neumannmachines?), maar alla.

Hij besloot met de vaststelling dat UX allerlei dingen absorbeert: zoals een spell checker vroeger een apart programma was, en daarna een aparte functie in een tekstverwerker maar tegenwoordig gewoon autocorrect en rode lijntjes onder verkeerd gespelde woorden is, zo zal agentieve technologie als nieuwe modus op den duur volledig normaal worden en in de achtergrond verdwijnen.

Zeer wijs, vond ik. Sympathieke mens, ook.