Er gaat geen week voorbij of ik denk er aan om iets te schrijven dat begint met Ik kan het haast niet geloven, maar het is al…

Yep, het zijn alweer bijna examens. De halfvastenfoor staat er al bijna, en dat wil zeggen dat het ook op de universiteit bijna examens zijn. Het was nog maar net nieuwjaar (de kerstverlichting hangt er bij ons nog), en het is al bijna paasvakantie.

En als het bijna paasvakantie is, wil dat zeggen dat het jaar bijna gedaan is. En dat we een dochter zullen hebben die universiteit zal doen. Aan de Blandijn, hoe hard ze het ondertussen ‘Campus Boekentoren’ ook willen noemen.

We zijn vandaag naar de infodag van de Letteren en Wijsbegeerte gegaan. “We”, ja. Ik en Zelie, niet wegens dat ze het niet zou kunnen zelf, of dat ze mijn hulp nodig heeft of wat dan ook, maar omdat het wijs is om dingen samen te doen, nu het nog kan.

Duuuuus: wij om negen uut stipt in auditorium E. Dat er vreemd genoeg precies zo uitziet zoals het in mijn geheugen zat — in tegenstelling tot de trappen aan de ingang van de Blandijn, die in mijn hoofd vier keer zo hoog waren als ze bleken te zijn.

Intro door de decaan, uitleg door Professor Bourgeois (hoeveel ik ook probeer, ik krijg Zelie maar niet in de richting geschiedenis en/of archeologie geduwd, pff), en dan een eerste testles. Latijn, niet omdat ze dat per se wil doen, maar wel omdat het ontderwerp er interessant uitzag: lineair lezen.

Nemen we een willekeurige Latijnse zin:

Belgae patrum nostrorum memoria omni Gallia vexata, Teutonos Cimbrosque intra suos fines ingredi prohibuerunt

Voor bovenstaande zin naar Caesar (DBG II.4) betekent dit een aanpak in volgende stappen:

- We slaan de hele zin over omdat het werkwoord normaal gezien aan het einde staat. Inderdaad vinden we daar de vervoegde vorm prohibuerunt en we gaan er dus van uit dat dit de persoonsvorm is.

- Intussen hadden we al wel in de gaten dat de zin begon met een vorm Belgae die op de plaats staat waar het onderwerp verwacht kan worden, namelijk zo ver mogelijk van de persoonsvorm af.

- Met een beetje geluk weten we dat het werkwoord prohibere zoiets betekent als ‘verbieden’ (anders lukt het ons misschien dit in het woordenboek tussen de verschillende mogelijkheden terug te vinden) en dan hebben we dus een lijdend voorwerp nodig. Dwalend door de zin komen we de groep Teutonos Cimbrosque tegen die in de accusatief staat en dus voldoet aan de eis voor het lijdend voorwerp.

- Nu beginnen de problemen want onze automatische piloot kan hier niet verder. Maar misschien beseffen we nog net dat je normaal gesproken iemand verbiedt om iets te doen. Dus hebben we een tweede werkwoord nodig, liefst in de infinitief. Inderdaad vinden we in de zin ook de vorm ingredi (en we gaan er even van uit dat iedereen deze deponente vorm onmiddellijk kan herkennen).

- Nu betekent ingredi zoiets als ‘binnengaan’. Dat betekent dus dat ergens binnengegaan moet worden en dat brengt ons bij het volgende element dat we nodig hebben: intra suos fines.

- Hier stopt het. Al de rest is invulwerk. Wat we nog geen plaats hebben gegeven (patrum nostrorum memoria omni Gallia vexata), proberen we nu op een of andere manier in te passen. Gelukkig bestaan daarvoor ook een paar standaardmethodes met als belangrijkste de Losse Ablatief: die past op elk potje zolang het om ablatieven gaat!

Wie zich als gepassioneerd lezer met Latijnse teksten bezig houdt, voelt hoe heel deze aanpak botst met de schoonheid van de teksten en met een realiteit die men niet kan ontkennen. Geen Romein kan op die manier gelezen hebben, want dan stelt zich de vraag waarom een schrijver het zijn lezers zo onmogelijk gemaakt heeft! Bovendien mag ik niet vergeten dat een Romein eigenlijk met zijn oren las: teksten werden geschreven om voorgelezen en dus gehoord te worden. ‘Stille’ lectuur bestond wel – althans in de zin van een individuele en persoonlijke lectuur – maar was niet de regel. Indien de analytische leesmethode nu vertaald wordt naar de Romeinse manier van lezen, blijkt een Romein een zin te hebben gehoord die allesbehalve Latijn is:

prohibuerunt Belgae Teutonos Cimbrosque ingredi intra suos fines patrum nostrorum memoria omni Gallia vexata

Het is duidelijk wat hier gebeurd is: het Latijn is benaderd alsof het Nederlands of om het eender welke moderne taal was. De analytische leesmethode heeft geen respect gehad voor de wijze waarop de Romein zijn taal benadert maar gedaan of deze gelijkgesteld mocht worden aan het moderne taalgebruik. Wie wenst te begrijpen wat er in de Latijnse zin dan wel aan de hand is, moet in de eerste plaats uitgaan van de woordvolgorde zoals deze in de Latijnse zin gehanteerd wordt.

Ja, zeer interessant en zo dus wel. De uitleg werd niet gegeven door Prof. Wim Verbaal zelf (tekst hierboven uit: Verbaal, Wim, “Leren lezen als Romeinen: niet enkel een kwestie van syntaxis!”, in De Herdt, Katja (red.), Taal in tekst. Taalbeschouwing in het klassieketalenonderwijs, Academia Press, Gent, 2015, p. 7-38) [is mijn citeerstijl eigenlijk nog in orde, vraag ik mij af?], al stond hij wel in het leslokaal achteraan te monkellachen. Het was een sympathieke meneer die ook in het echt leraar Latijn op een middelbare school was, en dat ik meteen zin had om weer Latijn te doen.

En dat het mij deed denken aan het fijne artikel over Reginald Foster, The Vatican’s Latinist, en hoe die een heel ander curriculum volgt dan klassiek (ha!) gedaan wordt:

The vast majority of students who study Latin study five or fewer authors (Caesar, Cicero, Vergil, Ovid, and Catullus), and take four or more years to see even those five. A select percentage of students may read as many as half a dozen more. But students who studied with Foster in 2011 read what can be found in Ossa: all of those five authors, plus Roger Bacon’s Compendium of Philosophy, Lucretius’s On the Nature of Things, the correspondence of Marcus Aurelius with his teacher Fronto, Seneca’s Consolation to Helvia, Raphael’s epitaph, the personal letters of Anselm of Canterbury, the dedicatory plaque of the cathedral of Milwaukee, Boccaccio’s On Famous Women, Tacitus on the Germans, Clement XIV on the suppression of the Jesuits, Kepler’s Commentary on Galileo’s Starry Messenger, Walter of Chatillon’s twelfth-century Satire Against the Curia, Antonius Galateus’s Hermit, Giovanni Pietro Maffei’s sixteenth-century description of China, documents from the Councils of Constance, Trent, Vatican I and II, and dozens more texts by dozens more authors: Livy, Raymond Lull, Ambrose, Bede, John Paul II, Thomas More, Tibullus, Plautus. Foster’s method put back together what language courses generally separate: the experience of learning a language and the cultural value of knowing it.

Daarna zijn we uitleg gaan vragen over hoe het jaar aan te pakken zou zijn als Zelie van september tot bijna eind februari in Engeland zit. Blijkt dat het allemaal wel kan, een half jaar later beginnen, maar dat het paradoxaal genoeg voor de meest vreemde vakken niet mogelijk is om in te pikken in het midden van het jaar. Engelse taalvaardigheid bijvoorbeeld: ik ga ervan uit dat het wel in orde zit met die taalvaardigheid, maar blijkbaar is het een cursus vol huiswerk en permanente evaluatie en zo, en dus pech: het is aanwezig te zijn.

Dan zou ze dus ergens op het einde van het parcours nog een half jaar cursussen te doen hebben, en heel de tijd te paard tussen twee jaar zitten. Ahem.

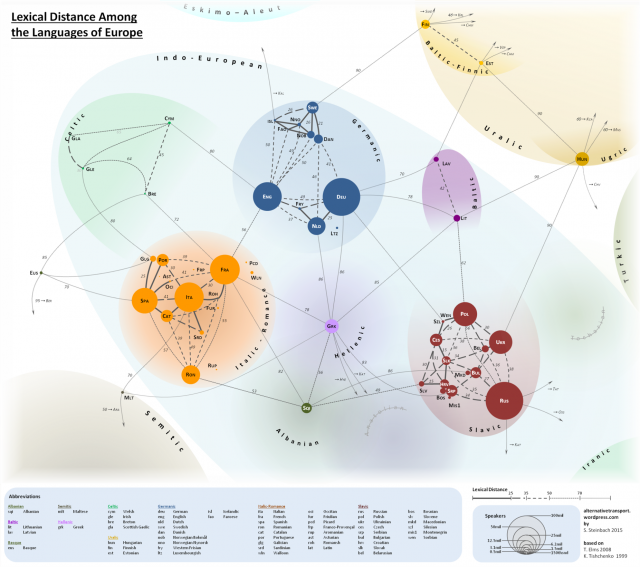

Tijd voor een tweede proefles. Ook niet dat ze dat ooit zou doen, maar uit leutigheid eens gaan luisteren naar Zweeds. Freek Adriaens ging meteen in het Zweeds. Los ervoor. En, gvd, los ook voor interactieve les. Ik heb sinds lang niet meer zo nerveus gezeten. Elke keer ik dacht dat het gedaan was, bleef hij verder doen. Jag kommer från Gent en ge moogt er zeker van zijn dat jag talar ingen svenska, ik zat daar met zweethanden dat hij mij er een tweede keer zou uitpikken.

We hebben na de les nog een paar studenten Duits gesproken, en die wisten ons te vertellen dat het meer voor de hand zou liggen om meteen te beginnen aan het begin van een academiejaar, maar dan eerst een paar vakken te doen die haar zouden interesseren — en misschien ook al een paar vakken zoals Visuele cultuur of Geschiedenis en cultuur van de Angelsaksische landen: dingen die in het tweede semester worden gegeven en geen voorkennis nodig hebben, maar wel al handig zouden zijn om achter de rug te hebben.

Gah. Klinkt niet verkeerd. Dan wordt het een interessant ‘eerste’ semester volgend jaar, en een iets lichtere eerste bachelor het jaar erna. Waar dan misschien weel wat plaats is voor nog wat bijkomende vakken.

En ja, het komt allemaal veel dichterbij, ja. Veel dichter. Zeer snel.

Jan was zondag vóór de middag terug, Louis na de middag. Jan zonder problemen, Louis met een zwaar verstuikte vinger aan zijn schrijfhand, en met een onbestemde ziekte.

Jan was zondag vóór de middag terug, Louis na de middag. Jan zonder problemen, Louis met een zwaar verstuikte vinger aan zijn schrijfhand, en met een onbestemde ziekte.